AI meditsiin: Kuidas kaitsta patsiendiandmeid ja luua usaldus?

- Andmekaitse meetodid: Patsiendi andmete privaatsus on tagatud rangete meetoditega (GDPR), nagu anonüümimine, pseudonüümimine ja uuenduslik föderatiivne õpe, mis võimaldab AI-d treenida, ilma et tundlikud andmed lahkuksid haigla turvalisest serverist.

- Vastutus on jagatud: Vastutus AI tehtud vigade eest on jagatud arsti, süsteemiarendaja ja teenusepakkuja vahel. Lõplik otsustusvastutus lasub alati koolitatud tervishoiutöötajal.

- Usaldus nõuab XAI-d: Usalduse loomiseks peab AI olema Selgitatav (XAI). See tagab, et süsteem ei tegutse “musta kastina,” vaid suudab põhjendada oma diagnoose ja prognoose.

- Eetiline väljakutse: Tuleb vältida algoritmilist erapoolikust, mis tekib ebaesinduslike andmekogumite tõttu. Patsientidel on õigus nõuda läbipaistvust, küsides, millistele andmetele AI prognoos tugineb.

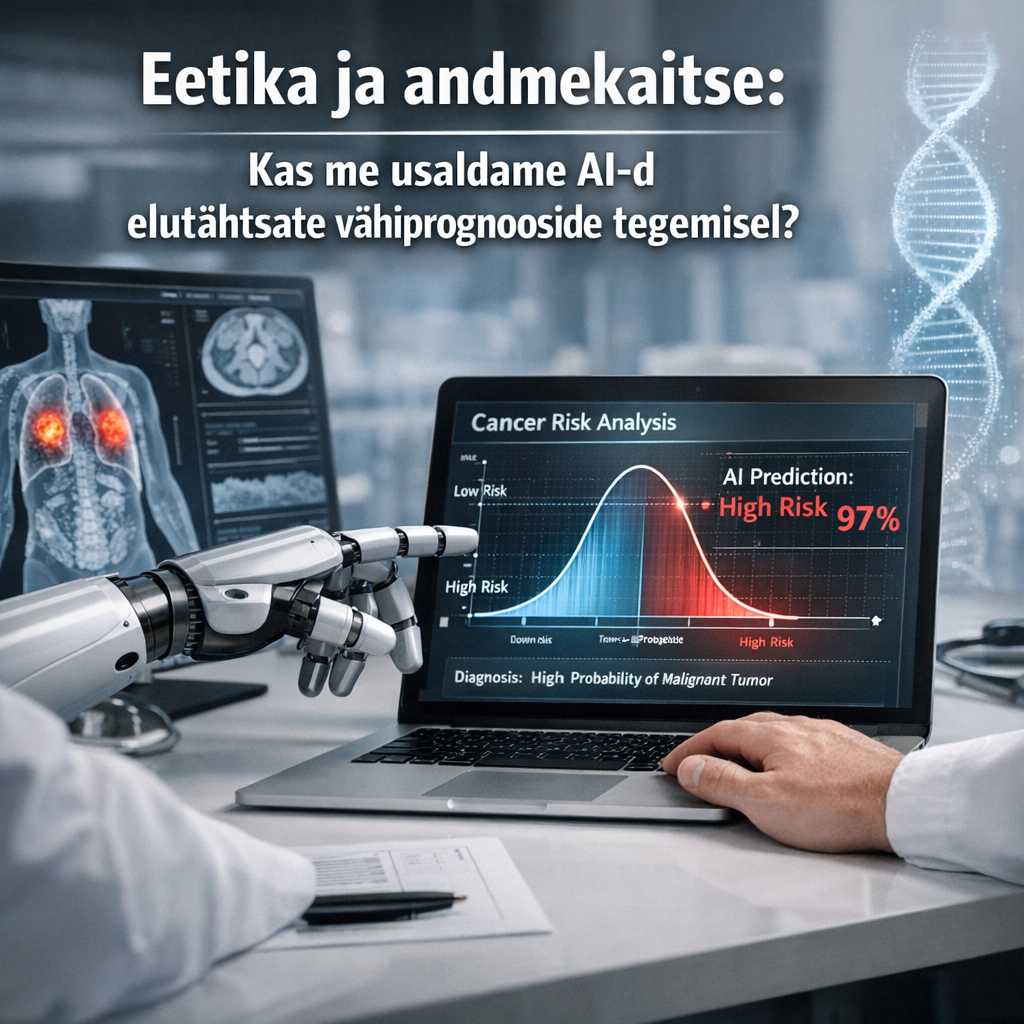

Eetika ja andmekaitse: Kas me usaldame AI-d sisukord

Kujuta ette olukorda, kus sinu lähedase elutähtis otsus, näiteks vähiravi prognoos, sõltub suurel määral tehisintellekti analüüsist. AI pakub kiirelt ja täpselt lahenduse, mis võib olla elupäästev.

Kuid samal ajal tead sa, et see süsteem on õppinud miljonite teiste inimeste tundlike andmete, sealhulgas sinu enda haigusloo peal. Kas sa suudaksid seda otsust pimesi usaldada?

See küsimus seisab täna meditsiini ja tehnoloogia ristteel. Selles artiklis selgitame sulle lahti, milliste reeglitega patsiendiandmete privaatsust tegelikult tagatakse.

Samuti vaatame, kuidas hinnata, kas AI-d saab kriitilistes meditsiinilistes otsustes usaldada ja kes vastutab, kui asi peaks viltu minema.

“Kuna tehisintellekt integreerub kliinilisse otsustusprotsessi, on põhiülesanne tagada läbipaistvus usalduse loomiseks ja luua selged vastutusraamistikud vigade ilmnemisel.” (Vastutuse ja Eetika Eksperdid)

Kuidas AI-d treenitakse, rikkumata sinu meditsiinilist privaatsust?

Meil Eestis on tugev usaldus oma e-tervise lahenduste vastu, kuid AI-süsteemide kasvuga kaasneb alati uus riskitase. Patsiendi tundlikud andmed, sinu geneetika, diagnoosid ja ravi, on kõige rangemalt kaitstud andmeliik üldse.

AI mudelid vajavad õppimiseks aga tohutult andmeid, tihti miljoneid haiguslugusid ja pilte. Siin tekibki peamine eetikakonflikt: kuidas me saame kasutada andmeid innovatsiooniks ja elupäästvate lahenduste loomiseks, rikkumata seejuures sinu privaatsust? AI tõstatab keerulisi eetilisi küsimusi, eriti seoses eelarvamuste, diskrimineerimise ja privaatsusega.

Õnneks on see valdkond rangelt reguleeritud. Euroopa Liidu GDPR (isikuandmete kaitse üldmäärus) ja Eesti tervishoiuteenuste korraldamise seadus panevad paika väga täpsed piirid, mida meditsiiniandmetega teha tohib.

AI arendajad kasutavad privaatsuse tagamiseks mitmeid võtmetehnikaid. Need tagavad, et sinu andmed on kaitstud isegi siis, kui neid kasutatakse uute algoritmide treenimiseks.

Usalduse küsimus: Kes vastutab AI otsuste eest?

AI suudab meditsiinilises pildianalüüsis olla uskumatult täpne, tuvastades vähikoldeid, mida inimsilm võib kergesti kahe silma vahele jätta. See on võimas tööriist, mis võib päästa elusid.

Aga mis juhtub, kui see täpne süsteem eksib? Vale diagnoosi puhul tekib kohe kriitiline küsimus: Kes vastutab? See vastutuse dilemma on meditsiinieetika kuumim arutelu teema, eriti Eestis, kus AI-lahendusi aktiivselt arendatakse.

Traditsiooniliselt lasub vastutus alati arstil, sest tema teeb patsiendi jaoks lõpliku otsuse. AI lisab aga süsteemi uue kihi, luues nn jagatud vastutuse.

See tähendab, et vastutus jaguneb arsti, AI-mudeli arendaja ja tervishoiuteenuse pakkuja vahel. Sa pead usaldama mitte ainult arsti, vaid ka seda, kes AI programmeeris ja milliste andmetega ta treeniti.

Selgitatav AI (XAI) on usalduse alus

Usalduse loomiseks on vaja läbipaistvust. Siin tulebki mängu:

Selgitatav AI (inglise keeles Explainable AI ehk XAI).

Kui enamik traditsioonilisi mudeleid töötavad nagu “must kast” (black box), andes ainult lõpptulemuse, siis XAI suudab näidata, miks ta just sellise otsuseni jõudis.

Mõtle sellele nii: kui AI prognoosib halba ravivastust, ei piisa vastusest “ei tööta”. XAI peab näitama, milliseid andmeid ja mustreid ta kasutas. Näiteks: “Prognoos saadi 9000 sarnase juhtumi põhjal, kus marker X oli 30% kõrgem.”

Ilma sellise põhjaliku selgituseta ei saa AI-d kriitilistes olukordades kasutada. Arst peab saama AI tulemuse kinnitada ja pakkuda sulle, patsiendile, põhjalikku ja arusaadavat põhjendust.

| Kriteerium | Inimese diagnoos | AI-põhine diagnoos |

|---|---|---|

| Vastutus | Arst (lõplik otsus) | Arst + Süsteemiarendaja (jagatud) |

| Põhjuslikkus | Lihtne (kogemus, testid) | Keeruline (algoritmiline) |

| Andmebaas | Piiratud (isiklik kogemus) | Massiivne (miljonid juhtumid) |

| Kontroll | ✅ Inimese kontroll | ⚠️ Vajab valideerimist |

See on ainus viis, kuidas saame tagada, et AI on arsti abiline, mitte pime otsustaja, ning et vastutus on selgelt jaotatud, kui midagi läheb valesti.

“See on ainus viis, kuidas saame tagada, et AI on arsti abiline, mitte pime otsustaja, ning et vastutus on selgelt jaotatud, kui midagi läheb valesti.” (Meditsiinilise AI Eetikaspetsialist)

Eetilised väljakutsed: Kuidas vältida algoritmilist erapoolikust?

Vastutus pole AI meditsiinis ainus kriitiline küsimus. Kui AI teeb elutähtsaid otsuseid, peame tagama ka õigluse. Eetika nõuab, et süsteem ei tohi hakata süvendama ühiskonnas juba eksisteerivat ajaloolist ebavõrdsust.

Kui süsteemi treenitakse andmetega, mis peegeldavad vanu mustreid, näiteks teatud rühmade aladiagnoosimist või puudulikku andmekogumist, tekib algoritmiline erapoolikus (või bias).

See tähendab, et masin õpib tegema vigu. Näiteks kui AI on õppinud peamiselt ühe etnilise rühma haiguslugude peal, võib ta teha teiste rühmade puhul ebatäpseid või isegi ohtlikke diagnoose.

See erapoolikus on eriti salakaval, sest AI otsus tundub sulle alati objektiivse ja matemaatiliselt põhjendatuna, isegi kui see on kallutatud.

Kuidas saame seda ohtu vältida ja tagada, et AI teeniks kõiki patsiente võrdselt?

- Andmete esinduslikkus: Peame tagama, et AI-d treenivad andmekogumid esindaksid tegelikku populatsiooni. See nõuab andmete kogumist, mis arvestaks vanust, sugu, etnilist kuuluvust ja sotsiaalmajanduslikku staatust.

- Eetikahindamine arenduses: Kaasa igasse AI-projekti juba algusfaasis eetikud, juristid ja patsiendi esindajad. Nende ülesanne on hinnata potentsiaalset kahju ja erapoolikuse riske.

- Regulaarsed auditid ja testimine: Algoritme tuleb süstemaatiliselt testida erinevate patsientide rühmade peal. See on ainus viis tuvastada ja parandada erapoolikus enne, kui süsteem jõuab kliinilisse kasutusse.

Lõppkokkuvõttes sõltub sinu usaldus AI vastu sellest, kas me suudame tagada, et süsteemid on nii õiglased kui ka vastutustundlikud.

Piirang ja hoiatus: AI ei ole võluvits

Teine kriitiline risk on seotud tundlike andmete privaatsusega. Isegi kõige paremini anonüümistatud andmebaasid võivad olla haavatavad, kui turvameetmed on ebapiisavad, tuues kaasa andmeleke ohu.

Proovi kohe: Uuri oma õigusi

AI kasutamine meditsiinis kasvab kiiresti. Sul, kui patsiendil, on õigus teada, kuidas sinu tundlikke andmeid selleks otstarbeks kasutatakse.

Andmekaitse ei ole abstraktne mure, vaid konkreetne tegevus, mida saad kohe ette võtta.

Sinu konkreetne samm (aeg: 5 minutit):

Mine oma haigla või tervisekeskuse kodulehele. Otsi sealt andmekaitsepõhimõtteid või privaatsustingimusi.

Kontrolli, kas nad on avaldanud info AI kasutamise kohta, või kas nad mainivad andmete anonüümimist.

Kui sa seda infot veebist ei leia, ära karda küsida otse oma perearstilt või eriarstilt. Teadlikkus on parim andmekaitse.

See on sinu tervis, sinu andmed, sul on täielik õigus nõuda läbipaistvust.

Edasi: Usalduse loomine läbi läbipaistvuse

Kui sa tunned, et kõik need regulatsioonid ja tehnilised detailid tunduvad esialgu segane, keskendu ühele põhimõttele: läbipaistvus.

See on meditsiinilise AI usaldusväärsuse nurgakivi. Me ei saa pimesi usaldada süsteemi, mis tegutseb nagu must kast (black box), annab vastuse, aga ei selgita, kuidas ta selleni jõudis.

Meie, patsiendid ja tarbijad, peame nõudma, et AI oleks seletatav. See tähendab, et süsteem ei paku ainult prognoosi (näiteks “vähirisk on 80%”), vaid näitab ka põhjendusi ja andmeid, millele ta tugineb.

Usaldus tekib siis, kui arst, kes AI tulemust kasutab, suudab sulle selgitada otsuse tagamaid. Arst peab olema valmis võtma vastutuse, isegi kui esialgse analüüsi tegi masin.

Mida sa saad teha? Küsi arstilt otse: “Kuidas see AI minu juhtumi puhul töötab ja mis andmetele see prognoos tugineb?” See aitab muuta abstraktse tööriista arusaadavaks ja usaldusväärseks.