See pole järjekordne lugu maailma vallutavatest robotitest. Pigem on see aus ja praktiline sissevaade ohtudesse, millest räägitakse liiga vähe. Sukeldume koos sellesse, miks tehisintellekt vahel justkui luiskab, mõeldes välja fakte, mida pole olemas. Ja uurime, miks see võib käituda eelarvamustega, ilma et keegi seda nii oleks programmeerinud.

Tehisintellekti ohud ja müüdid sisukord

Tehisintellekti varjatud pool

Oleme harjunud mõtlema tehnoloogiast kui millestki täpsest ja loogilisest – arvuti ju ei eksi, eks? Tehisintellekt aga seab selle arusaama tõsiselt kahtluse alla. Erinevalt tavalisest tarkvarast see mitte ainult ei arvuta, vaid ka õpib ja ennustab. See teeb temast uskumatult võimsa tööriista, aga toob kaasa ka täiesti uut tüüpi riskid.

See artikkel pole loodud hirmutamiseks. Vastupidi, minu eesmärk on tuua selgust. Tahan anda sulle lihtsa ja selge arusaama, et tehisintellekt pole mingi maagia, vaid keerukas tehnoloogia oma väga reaalsete piirangute ja ohtudega. Nende tundmine on oluline kõigile, mitte ainult programmeerijatele või andmeteadlastele.

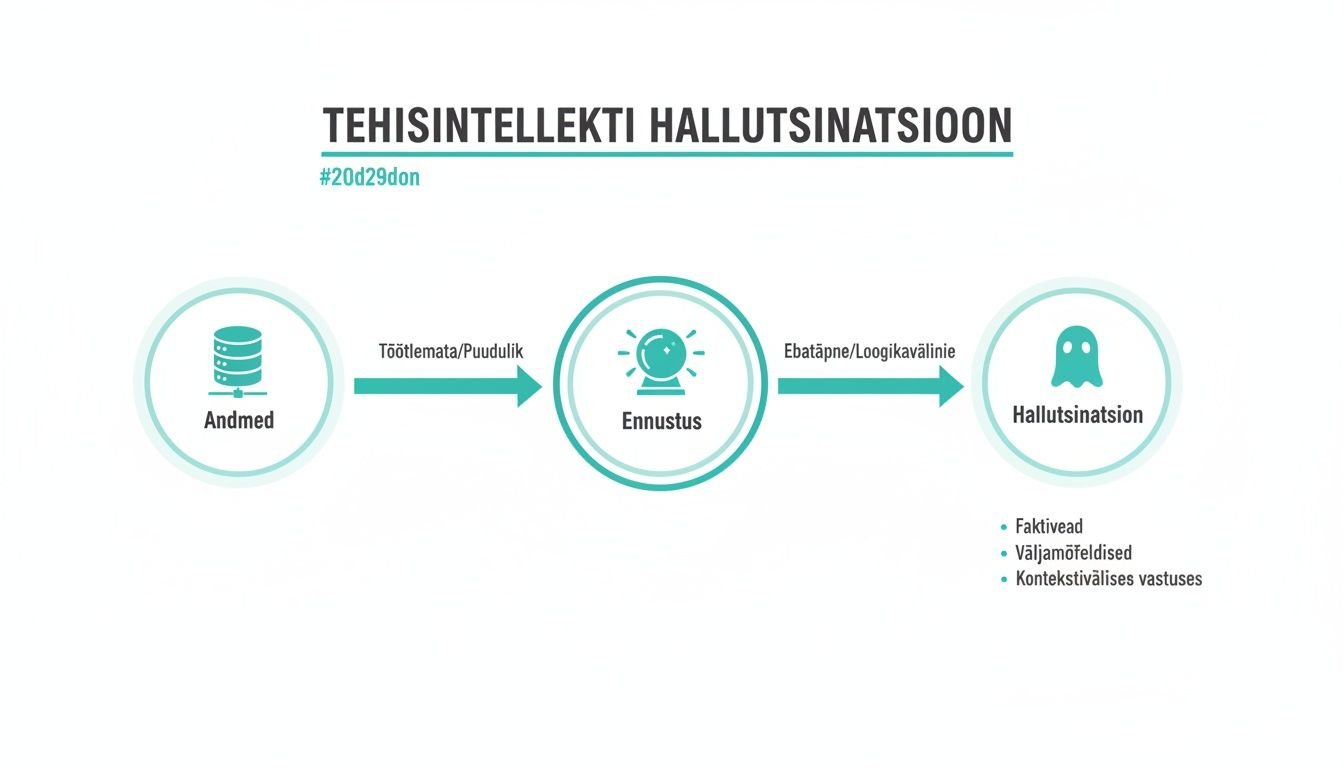

Näiteks kujuta ette, et kasutad AI-d koolitööks ja see genereerib sulle viite teadusuuringule, mis kõlab täiesti usutavalt. Sa lisad selle oma töösse, aga hiljem selgub, et sellist uuringut pole kunagi eksisteerinud. AI mõtles selle lihtsalt välja, sest see kõlas loogiliselt. See ongi AI hallutsinatsioon – üks peamistest teemadest, mida siin lahkame.

Mida sa siit artiklist õpid

Selleks, et saaksid AI-d kasutada targalt ja turvaliselt, keskendume kahele põhiprobleemile, mis puudutavad igaüht, kes tehisintellektiga kokku puutub:

- Hallutsinatsioonid: Uurime lähemalt, miks AI-mudelid, eriti suured keelemudelid (nagu ChatGPT taga olevad LLM-id ehk Large Language Models), mõnikord nii enesekindlalt valetavad. Selgitan, et see pole tingimata viga, vaid nende tööpõhimõtte omapära, ja annan nõu, kuidas sellist valeinfot ära tunda.

- Kallutatus ja eelarvamused: Süveneme sellesse, kuidas meie ühiskonnas eksisteerivad eelarvamused – näiteks soolised või rassilised stereotüübid – leiavad tee otse AI-süsteemidesse. Vaatame, kuidas andmed, millega AI-d treenitakse, võivad põhjustada ebaõiglasi või isegi kahjulikke otsuseid värbamisel, laenude andmisel ja mujal.

Tehisintellekti suurim oht ei ole see, et ta hakkab meid vihkama, vaid see, et ta õpib selgeks meie endi halvimad omadused ja võimendab neid globaalses mastaabis.

Lõppkokkuvõttes on teadlikkus parim kaitse. Kui sa mõistad, kust need ohud tulevad ja kuidas need avalduvad, saad astuda esimesed sammud, et end kaitsta ja tehisintellekti võimalusi maksimaalselt ära kasutada. See teekond algab siit – ausa ja otsekohese sissevaatega AI varjatud poolde, ilma keerulise žargooni ja tehnilise müstikata.

Miks tehisintellekt vahel fakte välja mõtleb

Oled sa kunagi küsinud ChatGPT käest midagi ja saanud vastu vastuse, mis tundub pealtnäha täiesti loogiline, aga hilisemal kontrollimisel osutub puhtaks väljamõeldiseks? Täpselt see ongi tehisintellekti hallutsinatsioon. Ja see pole mingi haruldane viga, vaid süsteemi sisseehitatud omapära.

Asja mõistmiseks piilume korraks kapoti alla. Suured keelemudelid (nagu näiteks ChatGPT aju) ei „tea“ fakte samamoodi nagu inimene. Nende ainus ülesanne on statistika põhjal ära arvata, milline sõna peaks lauses järgmisena tulema. Nad on justkui üliagarad õpilased, kes on küll terve raamatukogu läbi lugenud, aga pole millestki tegelikult aru saanud. Nad on õppinud ära mustrid ja seosed sõnade vahel.

Näiteks kui palud AI-l kirjutada kokkuvõtte teadusuuringust kohvi mõju kohta unele, käitub ta nii: kui tema treeningandmetes on palju sarnaseid artikleid, oskab ta perfektselt jäljendada teaduslikku stiili. Kui ta aga täpset vastust ei leia, võib ta enesekindlalt „luua“ olematu uuringu koos väljamõeldud teadlaste ja ajakirja viidetega. Miks? Sest just selline muster tundub talle statistiliselt kõige loogilisem.

Hallutsinatsioonid päris elus

See pole ainult teoreetiline mure. Väljamõeldud info võib tekitada väga reaalset kahju seal, kus täpsus on kriitilise tähtsusega. Mõned näited elust enesest:

- Õigusvaldkonnas: Üks USA advokaat kasutas ChatGPT-d kohtuasja materjalide ettevalmistamiseks. AI genereeris talle mitu varasemat kohtulahendit, mis toetasid tema argumente. Probleem? Mitte ühtegi neist pretsedentidest polnud tegelikult olemas. Advokaat seisis silmitsi sanktsioonidega, sest esitas kohtule väljamõeldud tõendeid.

- Ajakirjanduses: Mõned uudisteportaalid on katsetanud AI-ga artiklite kirjutamist. On juhtunud, et tehisintellekt on lisanud lugudesse täiesti valesid fakte või tsiteerinud inimesi, kes pole kunagi midagi sellist öelnud. See õõnestab lugejate usaldust ja levitab valeinfot.

- Meditsiinis: Kui arst või patsient otsib AI abil infot ja saab vastuseks soovituse, mis põhineb väljamõeldud uuringul, võivad tagajärjed olla lausa eluohtlikud.

AI hallutsinatsioon on nagu unenägu, mis tundub ärgates tõeline. Mudel ei valeta teadlikult – ta lihtsalt jutustab lugu, mis tema andmete põhjal tundub kõige usutavam, isegi kui see lugu on puhas fantaasia.

Põhjuseid on mitu. Esiteks on mudelit treenitud interneti andmetega, mis on täis vastuolulist infot, vigu ja arvamusi. Teiseks, kui mudel ei leia küsimusele täpset vastust, üritab ta olla abivalmis ja täita lüngad kõige loogilisemal viisil – mis paraku tähendab tihti info väljamõtlemist.

Kuidas end kaitsta

Kõige olulisem reegel tehisintellekti kasutamisel on: ära usalda pimesi! Isegi kui vastus tundub täiesti korrektne ja loogiline, suhtu sellesse alati kriitiliselt, eriti kui tegemist on oluliste faktidega.

Kontrolli alati fakte usaldusväärsetest allikatest. Kui AI annab sulle viite uuringule, otsi seda Google Scholarist. Kui ta mainib ajaloolist sündmust, kontrolli seda entsüklopeediast.

Tehisintellekt on võimas tööriist ideede genereerimiseks ja mustandite loomiseks, aga faktide kontrollimise vastutus jääb alati sinule.

Kuidas eelarvamused tehisintellekti sisse hiilivad

Oleme rääkinud, kuidas tehisintellekt võib fakte õhust võtta. Aga on veel teine, palju salakavalam oht – eelarvamused. AI ei ole oma olemuselt kuri ega ebaõiglane. Ta on pigem nagu peegel, mis näitab meile halastamatult seda, mida oleme talle õpetanud.

Ja kui me toidame teda andmetega, mis on täis meie ühiskonna ajaloolisi eelarvamusi, õpib ta need ilusti selgeks. Ja hakkab neid võimendama.

Näiteks kujuta ette, et AI on usin praktikant, kellele antakse ülesandeks lugeda läbi viimase 50 aasta personalidokumendid, et õppida, kes on hea töötaja. Kui nendes dokumentides on ajaloolistel põhjustel enamik juhte olnud mehed, teeb praktikant lihtsa ja loogilise järelduse: ju siis mehed ongi paremad juhid. See pole pahatahtlikkus, vaid puhas mustrite äratundmine.

Täpselt nii juhtubki tehisintellektiga. Kui värbamiseks loodud AI-tööriista treenitakse andmetega, kus minevikus on teatud ametikohtadel domineerinud üks sugu või rahvus, hakkab see süsteem alateadlikult eelistama sarnase profiiliga kandidaate. Ja mis kõige hullem – ta teeb seda täiesti objektiivse ja andmepõhise näoga, isegi kui kandidaatide oskused on identsed.

See skeem näitab küll, kuidas andmed võivad viia vigade või hallutsinatsioonideni, aga täpselt sama loogika kehtib ka eelarvamuste tekkimisel.

Kui algandmed on viltu, on ka tulemus viltu – olgu selleks siis faktiviga või ebaõiglane otsus.

Kust need eelarvamused tulevad?

AI kallutatus ei teki ühest kohast, vaid võib sisse hiilida protsessi igas etapis. Selleks, et end kaitsta, peame teadma, kust vaenlane ründab.

- Andmete kogumine: See on kõige levinum probleem. Kui andmestik ei esinda ühiskonda tervikuna, on tulemus käest ära. Näiteks kui näotuvastustarkvara on treenitud peamiselt heledanahaliste inimeste piltidega, töötab see teiste nahatoonidega inimeste puhul lihtsalt kehvemini. See pole arvamus, see on fakt.

- Andmete märgistamine: Paljud AI-süsteemid vajavad, et inimene andmetele sildid külge paneks (näiteks piltide sildistamine). Kui need märgistajad lähtuvad oma alateadlikest eelarvamustest, kanduvad need otse mudelisse üle.

- Mudeli treenimine: Isegi kui andmed on head, võib mudel ise õppida valesid seoseid. Ta võib avastada, et teatud postiindeksiga inimestel on kehvem krediidiajalugu, ja hakata selle alusel laenutaotlusi tagasi lükkama. Nii diskrimineerib ta terveid piirkondi, ilma et keegi oleks seda talle otseselt käskinud.

See pole ulme. Amazon pidi loobuma oma AI-põhisest värbamistööriistast, sest selgus, et see diskrimineeris süstemaatiliselt naiskandidaate. Süsteem oli õppinud ajaloolistest andmetest, et tehnoloogiasektoris on mehi rohkem, ja hakkas CV-dest karistama sõnade eest nagu „naiste“ (näiteks „naiste maleklubi kapten“).

Kallutatud tehisintellekt on nagu vigane kaal, mis näitab teatud inimeste jaoks alati valet numbrit. Sa võid seda kasutada heas usus, aga tulemused on süsteemselt ebaõiglased.

Ka Eestis on AI kasutamine plahvatuslikult kasvanud. Värskest uuringust selgub, et tehisintellekti kasutab juba 23% Eesti töötajatest. Tähelepanuväärne on, et kõrgepalgaliste seas on kasutusaktiivsus suurem. See viitab riskile, et tehnoloogia võib süvendada olemasolevat ebavõrdsust, kui me ei tegele teadlikult selle eetikaküsimustega. Lisateavet leiad siit uuringust Eesti töötajate AI kasutuse kohta.

Kuidas ebaõiglust märgata ja vähendada

Täielikult erapooletut AI-d on peaaegu võimatu luua, sest meie maailm ise pole erapooletu. Küll aga saame olla teadlikumad ja astuda samme riskide maandamiseks.

Nii arendajad kui ka kasutajad saavad anda oma panuse. Arendajad peavad hoolikalt valima ja puhastama treeningandmeid ning testima oma mudeleid erinevate inimgruppide peal. Lõppkasutajana on sinu roll olla kriitiline.

Kui kasutad AI-tööriista oluliste otsuste tegemiseks, küsi endalt alati:

- Kust tulevad andmed, mille põhjal see otsus tehti? Kas need võivad peegeldada ajaloolist ebavõrdsust?

- Kelle jaoks see tööriist ehitati? Kas seda on testitud ka inimeste peal, kes on minuga sarnased?

- Kas otsus on läbipaistev? Kas ma saan aru, miks AI just sellise vastuse andis, või on see „must kast“?

Mida rohkem me nõuame läbipaistvust ja õiglust, seda rohkem on ka arendajad motiveeritud looma paremaid ja eetilisemaid süsteeme. AI eetikaga seotud teemade sügavamaks mõistmiseks loe kindlasti meie artiklit, mis selgitab, kuidas selgitatav tehisintellekt (XAI) aitab AI otsuseid mõistetavaks teha. See on võti usalduse loomisel.

Levinumad müüdid tehisintellekti kohta

Filmid ja meedia on maalinud tehisintellektist pildi, mis on tihtipeale kaugel reaalsusest. Skynet, Terminaator, mässavad robotid – need on küll head lood, aga päriseluga on neil vähe pistmist. On aeg tõmmata eesriie kõrvale ja vaadata, mis tegelikult kapoti all peitub.

Esimene ja kõige suurem hirm on see, et tehisintellekt võtab ära kõik töökohad. See on arusaadav mure, kuid tegelikkus on palju nüansirikkam. Jah, AI automatiseerib kindlasti teatud ülesandeid, eriti rutiinseid ja korduvaid. See aga ei tähenda, et inimene muutuks üleliigseks.

Näiteks mõtle sellele nagu traktorile, mis asendas hobuse ja adra. Põllumees ei jäänud tööta, tema roll lihtsalt muutus – ta õppis juhtima masinat, mis tegi sama töö kordades kiiremini ja tõhusamalt. Samamoodi on AI pigem võimas tööriist, mis vabastab meid tüütutest kohustustest, et saaksime keskenduda sellele, milles oleme parimad: loovusele, strateegilisele mõtlemisele ja inimsuhetele.

Kas AI hakkab ise mõtlema?

Teine levinud müüt, mida Hollywood armastab, on iseteadliku ja inimkonna vastu mässava AI stsenaarium. Praegune tehisintellekt on aga sellest valgusaastate kaugusel. Isegi kõige võimsamad mudelid on oma olemuselt lihtsalt ülikeerukad matemaatilised programmid, mis on treenitud tohututest andmehulkadest mustreid leidma.

Neil puudub maailmast päris arusaam, neil pole emotsioone, soove ega kavatsusi. Kui sa küsid ChatGPT-lt midagi, siis ta ei „mõtle“ vastust välja. Ta ennustab statistiliselt kõige tõenäolisemat sõnade jada, mis sinu küsimusele peaks järgnema. See on muljetavaldav mustrite jäljendamine, mitte iseseisev mõtlemine.

Tehisintellekti võrdlemine inimmõistusega on nagu jalgratta võrdlemine linnuga. Mõlemad aitavad liikuda, aga nende tööpõhimõte ja olemus on täiesti erinevad.

Statistikaameti andmed kinnitavad seda trendi ka Eestis. Kui aasta tagasi kasutas mõnda AI-tehnoloogiat 5% ettevõtetest, siis nüüdseks on see number kasvanud 14%-ni. See näitab, et AI ei võta üle, vaid integreerub spetsiifiliste ülesannete lahendamiseks. Loe lähemalt Eesti ettevõtete tehnoloogiakasutuse kohta Statistikaameti lehelt.

AI ja loovuse piirid

Ja lõpetuseks – kas AI suudab luua tõelist kunsti? See on kuum aruteluteema. Tehisintellekt suudab kahtlemata luua visuaalselt vapustavaid pilte, liigutavat muusikat ja isegi luulet. Aga kas see on loomingulisus või lihtsalt meisterlik olemasolevate mustrite kombineerimine?

Praegused AI-mudelid õpivad inimeste loodud kunstist. Nad analüüsivad miljoneid maale, laule ja tekste ning õpivad ära stiilid, tehnikad ja struktuurid. Seejärel saavad nad neid elemente uuel viisil kokku segada. Tulemus võib olla originaalne, kuid selle taga pole inimlikku kogemust, emotsiooni ega kavatsust – neid tundeid, mis on tõelise kunsti südames.

Selleks, et müra seest tõde leida, vaatame üle mõned kõige levinumad väärarusaamad ja paneme need kõrvuti tegelikkusega.

Levinud AI müüdid ja tegelikkus

| Müüt | Tegelikkus |

|---|---|

| AI võtab ära kõik töökohad. | AI muudab töö iseloomu, automatiseerides rutiinseid ülesandeid ja toimides inimese võimsa tööriistana. |

| AI muutub iseteadlikuks. | Praegune AI on mustrite tuvastamise tööriist, millel puudub teadvus, emotsioonid või oma kavatsused. |

| AI on alati objektiivne. | AI õpib andmetest. Kui andmed on kallutatud, on ka AI otsused kallutatud ja peegeldavad inimlikke eelarvamusi. |

| AI suudab luua tõelist kunsti. | AI jäljendab ja kombineerib inimeste loodud mustreid, kuid sellel puudub loomingulisuse inimlik alus – elukogemus ja emotsioon. |

Seega, AI on pigem uskumatult andekas papagoi kui mõtlev kunstnik. Ta suudab ideaalselt jäljendada, aga mitte luua midagi täiesti uut, mis põhineks elukogemusel. Kokkuvõttes on oluline hoida pea külmana ja suhtuda tehisintellekti realistlikult – see on võimas vahend, mitte maagiline kõikvõimas olend.

Kuidas tehisintellekti turvaliselt kasutada

Oleme nüüd rääkinud tehisaru varjukülgedest – faktide väljamõtlemisest kuni ühiskondlike eelarvamuste võimendamiseni. Nüüd on aeg minna praktiliseks. Hea uudis on see, et sa ei pea olema programmeerija ega andmeteadlane, et end kaitsta. Piisab täiesti tervest mõistusest ja mõnest heast harjumusest.

Mõtle sellest kui oma isiklikust AI turvalisuse kontrollnimekirjast. Need neli sammu on sinu kaitsekilp iga kord, kui kasutad mõnda AI-tööriista, olgu selleks siis tekstide loomine, piltide genereerimine või andmete analüüs. Need nipid aitavad sul uues AI-maailmas palju enesekindlamalt ja turvalisemalt toimetada.

See teema puudutab peaaegu kõiki. Statistikaameti andmetel on pea pooled eestlastest AI-ga juba kokku puutunud, sest internetiühendusega leibkondade osakaal on Eestis lausa 95%. See tähendab, et teadlikkus AI ohtudest on muutumas sama elementaarseks oskuseks nagu parooli valimine.

Reegel nr 1: Ära usalda pimesi

See on kõige olulisem põhimõte üldse. Tehisintellekt ei ole tõe allikas, vaid ülimalt osav mustrite generaator. Isegi kui vastus tundub täiesti loogiline ja on esitatud veenvalt, suhtu sellesse alati tervisliku skepsisega.

Näiteks kui palud AI-l otsida infot Eesti majanduskasvu kohta, ära kopeeri esimest vastust pimesi. Otsi üles originaalallikad, nagu Statistikaamet või Eesti Pank, ja võrdle andmeid. See väike lisasamm säästab sind potentsiaalselt suurest piinlikkusest.

Faktide kontrollimine on ja jääb sinu vastutuseks. Kui kasutad AI-d uurimistööks, koolitööks või olulise e-kirja koostamiseks, siis veendu, et kõik väited ja numbrid peavad paika.

Reegel nr 2: Hoia oma andmed endale

Kujuta ette, et AI-vestlusaken on avalik ruum, näiteks bussipeatus. Sa ei jagaks ju seal võõra inimesega oma pangakaardi andmeid, isikukoodi või firma ärisaladusi. Täpselt sama loogika kehtib ka siin.

Paljud suured keelemudelid (LLM-id ehk Large Language Models) kasutavad sinu sisestatud vestlusi oma algoritmide edasiseks treenimiseks. See tähendab, et kõik, mida sa sinna kirjutad, võib potentsiaalselt saada osaks mudeli tulevastest teadmistest ja lekkida teistele kasutajatele.

Ära kunagi sisesta AI-vestlusaknasse isiklikku, konfidentsiaalset või tundlikku infot. See hõlmab kõike alates sinu kodusest aadressist ja lõpetades firma uue toote arendusplaanidega.

Andmekaitse on AI-ajastul kriitilisem kui kunagi varem. Kui tahad sügavamalt mõista, milliseid andmeid ei tohi AI-le anda, siis loe kindlasti meie põhjalikku juhendit: https://tehisarukas.ee/andmekaitse-ja-ai-mida-sa-ei-tohi-tehisisarule-anda/.

Reegel nr 3: Õpi märkama kallutatust

Nagu varem rääkisime, õpib AI meie enda andmetest – ja seega ka meie enda eelarvamustest. Selleks, et mitte pimesi ebaõiglaseid mustreid korrata, on oluline olla kriitiline ja esitada endale kontrollküsimusi.

Kui saad AI-lt vastuse, mis puudutab inimesi või sotsiaalseid gruppe, küsi endalt:

- Kas see vastus põhineb stereotüüpidel? Näiteks kui AI seostab teatud ameteid ainult ühe sooga.

- Kas see üldistab liiga julgelt? AI võib teha laiaulatuslikke järeldusi väga väikese andmehulga põhjal.

- Kelle vaatenurk on esindatud ja kelle oma puudub? Vastus võib peegeldada domineerivat kultuurilist vaadet, jättes kõrvale vähemuste arvamused.

Näiteks tee väike praktiline test: palu AI-l luua pilt „edukast juhist“. Kas tulemus on alati valge keskealine mees ülikonnas? Kui jah, siis proovi käsklust täpsustada, paludes näiteks luua pildi „edukast naisjuhist Aafrikast“. Nii aitad murda stereotüüpe nii enda mõtlemises kui ka AI-s.

Reegel nr 4: Anna alati tagasisidet

Viimane, aga mitte vähem oluline samm on aktiivne osalemine. Enamik AI-tööriistu, nagu ChatGPT, pakuvad võimalust anda vastustele tagasisidet – näiteks pöidlaga üles või alla. Kasuta seda!

Kui märkad, et AI hallutsineerib (mõtleb fakte välja), annab kahjulikke soovitusi või on selgelt kallutatud, anna sellest arendajatele teada. Sinu tagasiside on justkui õpetaja, kes parandab õpilase vigu. Iga selline märguanne aitab arendajatel oma mudeleid täpsemaks, turvalisemaks ja õiglasemaks muuta. See on väike panus sinu poolt, aga sellel on suur mõju kogu ökosüsteemile.

Lõppsõna: kuidas olla tark AI kasutaja?

Olemegi selle teekonna lõppu jõudnud ja on aeg otsad kokku tõmmata. Kui sellest kõigest jääb meelde vaid üks mõte, siis olgu see järgmine: tehisintellekt ei ole iseenesest hea ega halb. See on lihtsalt uskumatult võimas tööriist. Selle tegelik mõju sõltub ainult sellest, kuidas meie, inimesed, otsustame seda kasutada.

Tark AI kasutaja ei karda uut tehnoloogiat, aga ta ei ole ka pimesi armunud. Ta mõistab selle piiranguid. Ta teab, et hallutsinatsioonid ja eelarvamused pole pelgalt teoreetilised ohukohad, vaid reaalsed väljakutsed, millega tuleb iga päev arvestada.

Targa kasutaja põhimõte on lihtne: tehisintellekt on suurepärane abiline, aga vastutus jääb alati inimesele.

Lõpetuseks tahan sind julgustada jätkama õppimist ja katsetamist. Mida rohkem me nendel teemadel räägime, kogemusi jagame ja üksteist harime, seda turvalisema ja arukama AI-tuleviku suudame ühiselt luua. Ole uudishimulik, kriitiline ja mis kõige tähtsam – ole tark kasutaja.

Korduma kippuvad küsimused

Siin on mõned ausad ja otsekohesed vastused küsimustele, mis tehisintellekti ohtude ja eetika teemadel tihti kerkivad.

Kas tehisintellekt valetab meelega?

Ei, tehisintellekt ei valeta teadlikult, sest tal puudub inimlik tahe, emotsioonid või teadvus. Kui AI esitab valeinfot, siis tehnilises keeles nimetatakse seda “hallutsinatsiooniks”.

See juhtub siis, kui mudel ei leia sinu küsimusele täpset vastust oma andmetest. Selle asemel, et öelda “ma ei tea”, proovib ta lünga täita, luues statistiliselt kõige tõenäolisema sõnade jada. Tulemus võib kõlada väga enesekindlalt ja veenvalt, aga olla faktiliselt täiesti vale. Mudeli jaoks on see lihtsalt mustrite jätkamine, mitte teadlik petukatse.

Kuidas ma saan AI-d kasutades oma andmeid kaitsta?

Kõige tähtsam reegel on see: ära kunagi jaga vestlusaknas isiklikku või tundlikku infot. Mõtle sellest kui avalikust foorumist, mitte privaatsest vestlusest. See kehtib kõige kohta – sinu isikukoodist ja kodusest aadressist kuni ettevõtte ärisaladuste või klientide andmeteni.

Paljud avalikud AI-mudelid kasutavad sinu sisestatud vestlusi oma süsteemi edasi treenimiseks. See tähendab, et info, mille sa sinna kirjutad, võib saada osaks mudeli teadmistepagasist ja potentsiaalselt lekkida teistele kasutajatele. Hoia oma konfidentsiaalne info endale.

Kas AI kasutamine on eetiline?

See küsimus pole tegelikult tehnoloogiast, vaid inimestest. Küsimus on selles, kuidas me AI-d kasutame. Tehisintellekti rakendamine on eetiline siis, kui seda tehakse vastutustundlikult, läbipaistvalt ja inimeste heaolu silmas pidades.

See tähendab, et me peame olema teadlikud ohtudest, nagu andmete kallutatus või valeinfo levik, ja aktiivselt töötama nende riskide maandamise nimel. Lõppkokkuvõttes jääb vastutus alati inimesele – nii arendajale, kes süsteemi loob, kui ka kasutajale, kes selle abil otsuseid teeb.

Eetiline AI kasutamine ei ole ühekordne projekt, mille saab valmis teha. See on pidev protsess, mis tähendab tehnoloogia rakendamist viisil, mis austab inimõigusi, edendab õiglust ega tekita kahju.

Miks on AI kallutatus nii suur probleem?

AI kallutatus on ohtlik, sest see võimendab ja automatiseerib ühiskonnas juba olemasolevat ebavõrdsust. Kui AI-süsteem on treenitud andmetega, mis peegeldavad ajaloolisi eelarvamusi (näiteks soolist või rassilist diskrimineerimist), hakkab see neid mustreid kordama ja tegema süsteemselt ebaõiglaseid otsuseid.

Näiteks võib selline mudel hakata tööle kandideerimisel eelistama mehi, jätta teatud gruppidele laenu andmata või suunata politseiressursse ebaõiglaselt kindlatesse linnaosadesse. Ja kuna AI teeb otsuseid sageli ülisuures mahus ja automaatselt, võib üheainsa kallutatud algoritmi mõju olla kordades laastavam kui üksiku inimese eelarvamus. See muudab olemasolevad probleemid veelgi sügavamaks ja raskemini lahendatavaks.

Tehisarukas on sinu teejuht AI-maailmas. Liitu meie kogukonnaga, et õppida, kuidas tehisintellekti nutikalt ja turvaliselt enda kasuks tööle panna. Suhtle teist AI huvilistega, küsi nõu, avasta uusimad tööriistad, praktilised juhendid ja nõuanded aadressil: https://whop.com/tehisarukas/eesti-ai-kogukond/